Présentation de Lara

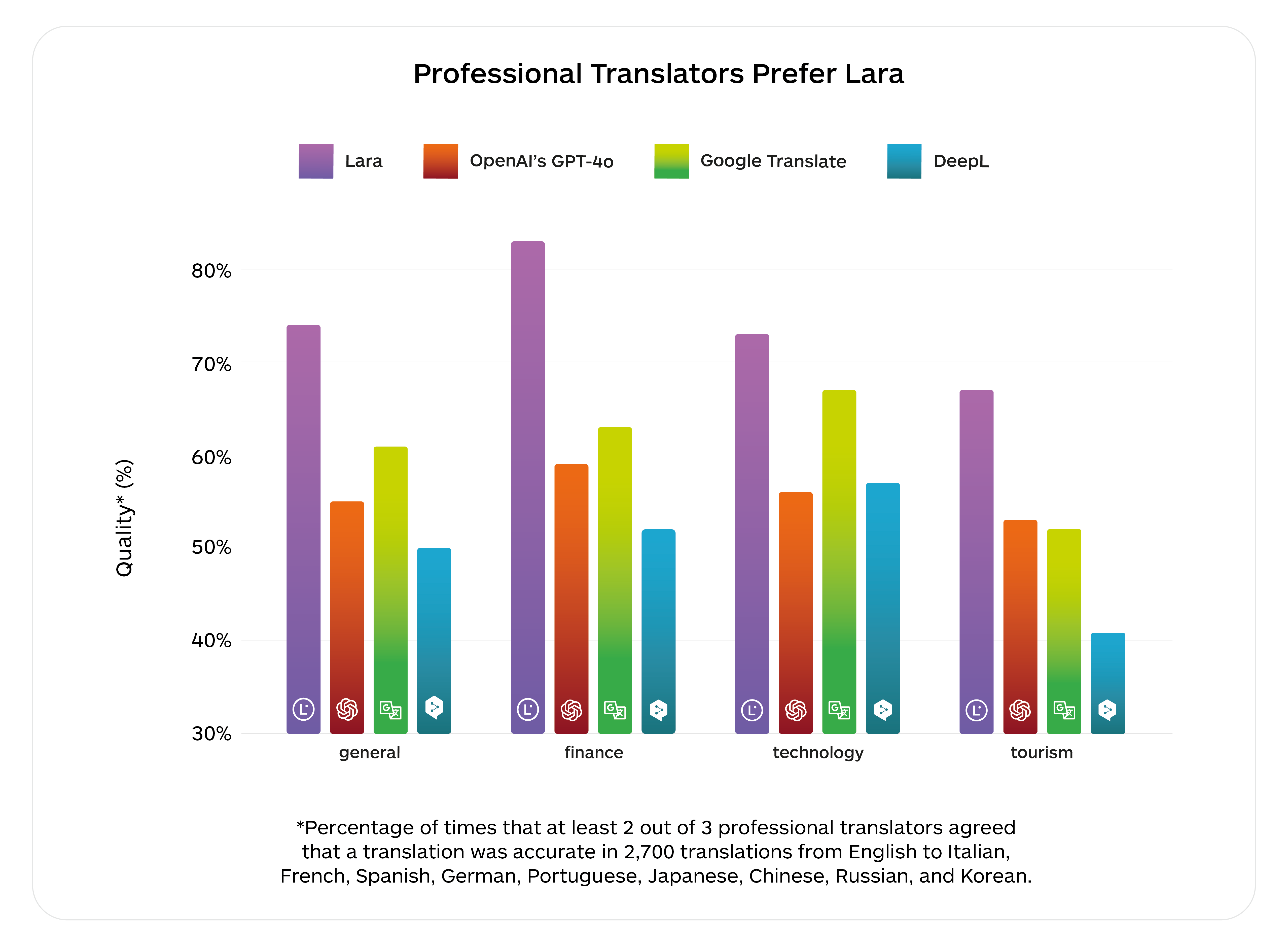

Notre PDG, Marco Trombetti, a présenté Lara, l’aboutissement de plus de 15 ans de recherche en traduction automatique. En 2011, nous étions les pionniers de la TA adaptative. Depuis 2017, nous alimentons notre système de TA neuronal avec le modèle Transformer, conçu pour la traduction et devenu plus tard un élément fondamental de l’IA générative. Lorsque les grands modèles linguistiques ont gagné en popularité après la sortie de ChatGPT, beaucoup ont été impressionnés par leur fluidité et leur capacité à gérer de larges contextes, mais également frustrés par leur manque de précision. Nous travaillions déjà sans relâche pour combiner la puissance des grands modèles linguistiques avec la précision de la traduction automatique. Aujourd’hui, nous sommes fiers d’avoir atteint cette étape importante en combinant ces deux modèles au sein de Lara, la meilleure IA de traduction au monde.

Lara redéfinit la traduction automatique telle que nous la connaissons en expliquant ses choix, en s’appuyant sur une compréhension contextuelle et un raisonnement approfondi pour offrir des traductions de qualité professionnelle en lesquelles les utilisateurs peuvent avoir confiance. Elle est entraînée sur le plus grand ensemble de données de traductions du monde réel. Ce dernier est aussi le mieux organisé qui soit à l’échelle mondiale. Grâce à notre collaboration à long terme avec NVIDIA, Lara a été entraînée sur la plateforme d’IA NVIDIA en utilisant 1,2 million d’heures de GPU.

Avec Lara, les entreprises peuvent s’attaquer à des projets de localisation jusqu’alors inimaginables. Les traducteurs et les créateurs multilingues apprécieront Lara dans leur travail quotidien : elle leur permettra d’atteindre de nouveaux niveaux de productivité et de précision.

Le taux d’erreur de Lara n’est que de 2,4 pour mille mots. En 2025, nous visons une planification encore plus élevée pour exploiter 20 millions d’heures de GPU afin de nous rapprocher davantage de la singularité linguistique.