Præsentation af Lara

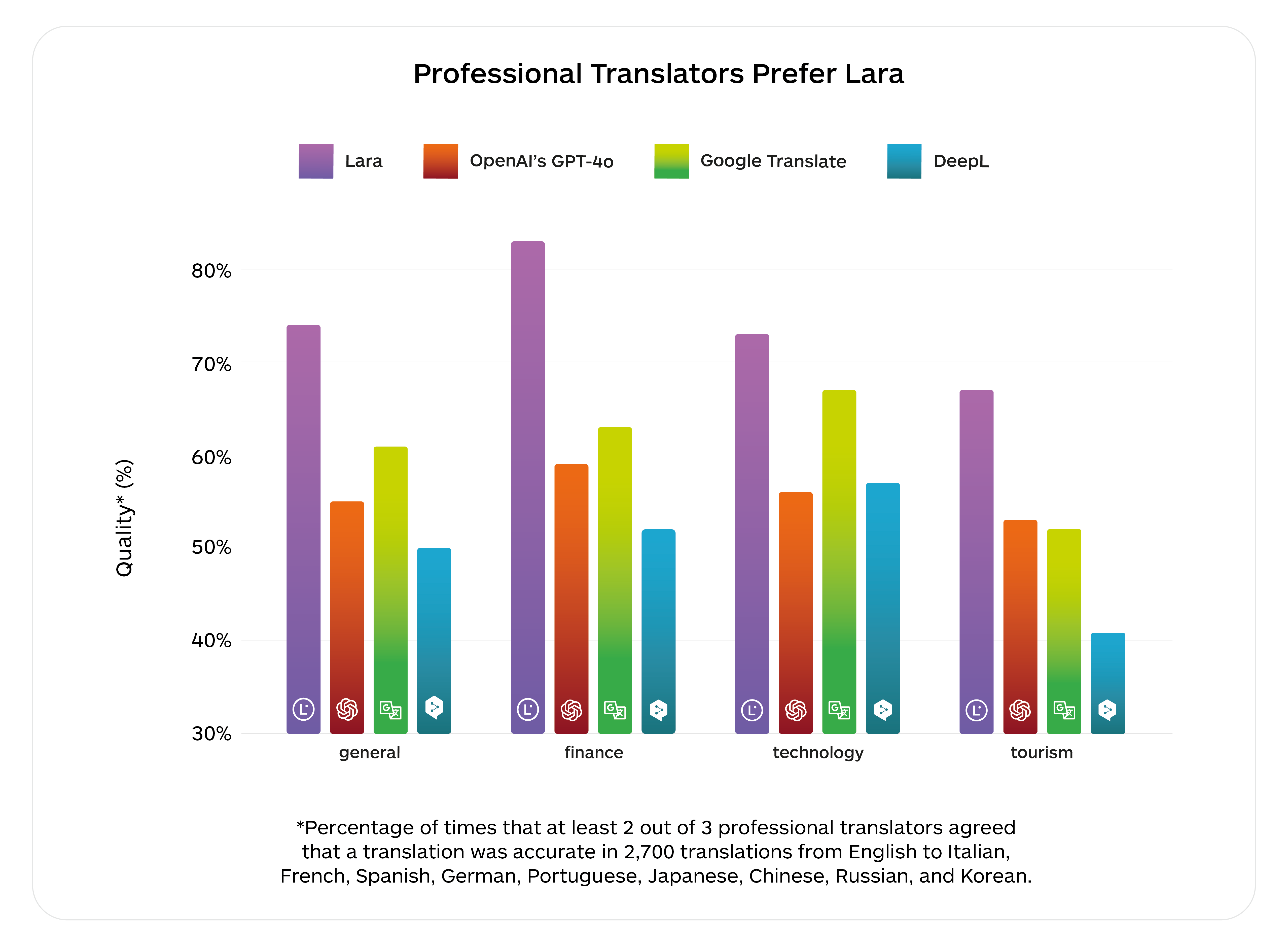

Vores administrerende direktør, Marco Trombetti, præsenterede Lara, der er kulminationen på over 15 års forskning i maskinoversættelse. I 2011 var vi pionerer inden for adaptiv MT. Siden 2017 har vi drevet vores neurale MT-system med Transformer-modellen, som blev opfundet til oversættelse og senere blev grundlæggende for generativ AI. Da store sprogmodeller blev populære efter udgivelsen af ChatGPT, blev mange forbløffet over, hvor flydende de var, og deres evne til at håndtere store sammenhænge – men de blev også frustrerede over deres manglende nøjagtighed. Vi arbejdede allerede utrætteligt på at kombinere styrken hos store sprogmodeller med nøjagtigheden i maskinoversættelse. I dag er vi stolte af at have nået denne milepæl ved at kombinere begge med Lara, verdens bedste oversættelses-AI.

Lara omdefinerer maskinoversættelse ved at forklare sine valg, udnytte kontekstuel forståelse og ræsonnement til at levere professionelle oversættelser, som brugerne kan stole på. Den er uddannet i det største, mest kuraterede datasæt af virkelighedens oversættelser, der er tilgængelige på verdensplan. Lara blev uddannet på NVIDIA AI-platformen ved hjælp af 1,2 millioner GPU-timer takket være vores langsigtede samarbejde med NVIDIA.

Med Lara kan virksomheder tackle lokaliseringsprojekter, man tidligere ikke kunne forestille sig. Oversættere og flersprogede kreatører vil nyde godt af Lara i deres daglige arbejde og opnå nye niveauer af produktivitet og nøjagtighed.

Laras fejlrate er kun 2,4 pr. tusind ord. I 2025 sigter vi endnu højere: Vi planlægger at udnytte 20 millioner GPU-timer til yderligere at nærme os sproglig singularitet.